El análisis de logs de servidores se trata de una de las acciones más interesantes que podemos realizar en un proyecto SEO. ¿A qué nos referimos con analizar los logs desde un punto de vista SEO?

Básicamente, a comprobar cómo se comportan los bots que entran a nuestro sitio web (frecuencia con la que pasan, URLs más rastreadas, etc.).

Contenidos

¿Qué es un log de servidor?

Se trata de un fichero, que se almacena en el servidor, donde queda reflejada toda actividad que se ha producido. Cualquier petición realizada al servidor aparecerá reflejada. Si nos ponemos a analizar un log veremos que hay muchos tipos de bots (Googlebot, SEMrush, Sistrixbot, Bingbot…).

Debemos tener claro que estos datos vienen directamente del servidor, por lo que no se pierde información por el camino.

¿Qué contiene un archivo log?

Este es el aspecto de una línea en un archivo de logs:

66.249.64.239 – – [09/Sep/2020:00:00:01 +0200] «GET /ficha-producto-xyz/ HTTP/1.1» 200 7367 «-» «Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)»

Principales aspectos a tener en cuenta:

- IP: IP del cliente solicitante (66.249.64.239).

- Fecha y hora: A qué hora ha pasado ese bot

- Tipo de petición: Determinar si es GET o POST

- URL rastreada

- Protocolo: En este casi HTTP/1.1

- Código de respuesta: En este caso 200

- User agent: Googlebot/2.1

Normalmente, tendremos un archivo de logs por cada día.

¿Cómo poder descargarlos?

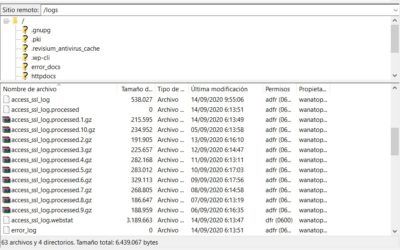

Dependerá de cada hosting, pero lo habitual es que, conectándote a tu servidor (por ejemplo, usando FileZilla), tengas una carpeta llamada logs donde se vaya acumulando. Desde ahí simplemente hay que darle a descargar y ya tendrás los archivos comprimidos en ZIP.

Si no tenemos un programa tipo FileZilla podemos entrar directamente al panel de nuestro hosting y acceder al cPanel o Plesk para poder descargarlos desde allí.

¿Cómo nos puede ayudar en SEO?

Como hemos comentado al inicio del post, el análisis de logs enfocado a SEO es un arma muy poderosa. Podemos analizar cuáles son las urls más rastreadas por Googlebot, si se está perdiendo por zonas que no nos interesan, el código de respuesta de las urls que visita, etc. ¡Vamos, información valiosísima!

En páginas grandes (con millones de urls) es vital conocer en qué “gasta” Googlebot el tiempo en rastrear. Gracias a los logs podríamos descubrir si se está empleando presupuesto de rastreo en secciones de poco impacto de negocio o en urls que devuelve un código de respuesta 404.

¿Cuál es la mejor manera de visualizar un análisis de logs?

Como hemos visto antes, una línea de log tiene bastante información. Imagina eso multiplicado por miles/millones. Lo ideal es utilizar herramientas de visualización de datos y poder plasmarlo en dashboards.

Tenemos distintas opciones para poder realizar este análisis.

- Herramientas en las que conectas con el servidor y te los “pinta” (Botify, Fandango SEO, OnCrawl, Seolyzer…)

- Herramientas como Screaming Frog Log Analyzer o SEMrush, donde tú descargas los logs y lo vuelcas en la herramienta (no tan automático como la anterior opción).

- Una tercera opción más personalizada es crear un dashboard en Data Studio (como nos explica Suganthan Mohanadasan en este magnífico post) o tirar de herramientas como Kibana y Elasticsearch para construir tu propio panel.

Herramientas SEO para analizar logs

Vamos a analizar algunas de las herramientas que pueden ser muy útiles para hacer este tipo de análisis.

Screaming Frog Log Analyzer

Probablemente de las mejores opciones por calidad/precio. Se trata de la versión “log” de la rana, donde tenemos que subir los archivos de manera manual (descargándolos previamente como hemos explicado). La versión gratuita te deja crear un proyecto y cargar 1000 eventos.

Nos da información muy interesante:

- Verificación de que son bots auténticos y no fakes (por ejemplo, un crawler que emula a Googlebot)

- Posibilidad de ver por tipo de bot (Googlebot, Bingbot, etc.)

- Elegir el periodo que se quiere analizar

Lo primero que tenemos que hacer es descargar los logs (como hemos comentado antes) desde nuestro servidor y crear un proyecto dentro de Screaming Frog Log Analyzer.

Una vez lo tenemos creado solo tenemos que cargar los archivos y la herramienta nos pintará los datos.

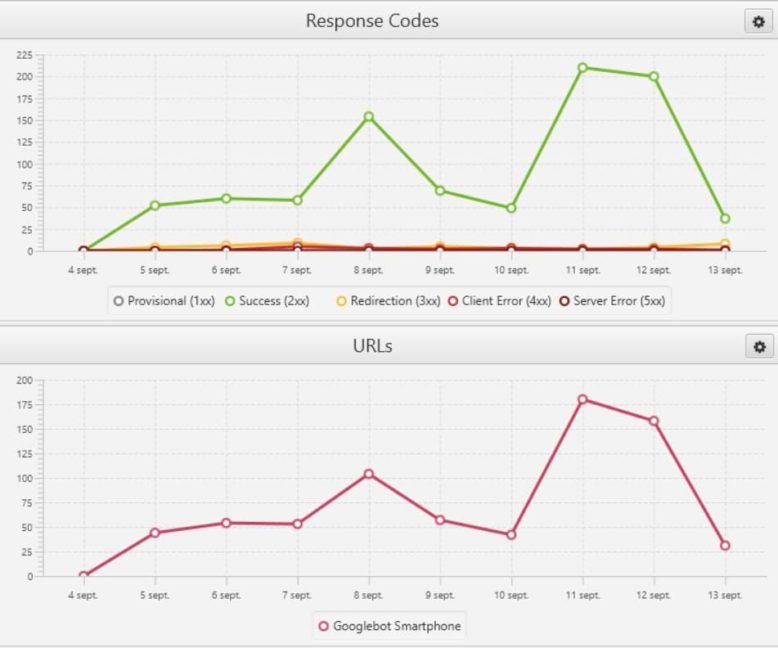

En la pestaña de overview podemos ver un resumen gráfico de los logs

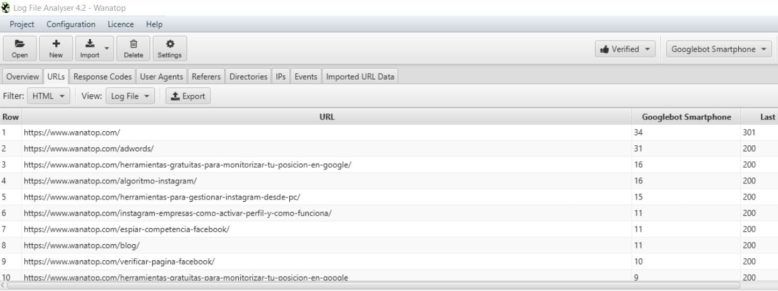

En urls podemos indagar viendo cuáles son las urls más rastreadas, el código de respuesta, etc.

TIP: Una cosa muy chula que podemos hacer es descubrir urls huérfanas cruzando un crawl de Screaming Frog Spider con un proyecto de Screaming Frog Log Analyzer.

- Realizar un crawl y lo guardamos

- Lo subimos al proyecto que tenemos creado en SF Log y cruzamos los datos

- De esta manera podremos ver urls que reciben hits de Googlebot, pero que no aparece en el crawl realizado en SF (por lo que no está enlazada correctamente) pinchando en Not in Url data.

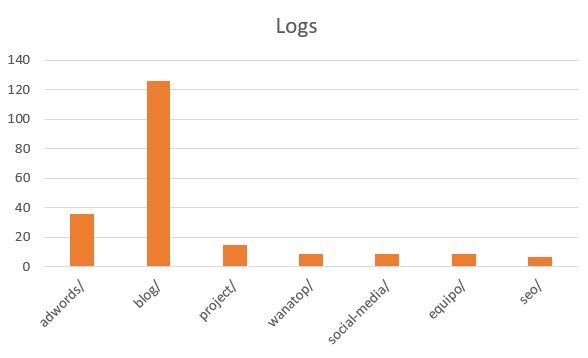

Además, si combinamos Excel y SFL podemos ver de manera muy visual lo más crawleado por Googlebot. Dentro de directorios, ordenamos por eventos y pintamos luego el gráfico en Excel.

Semrush Log File Analyzer

Si tienes la suite de SEMrush puedes hacer uso de su sección de análisis de logs. No es un apartado muy conocido, pero nos da datos interesantes. Un punto negativo con respecto a Screaming Frog es que no te deja subir los archivos comprimidos.

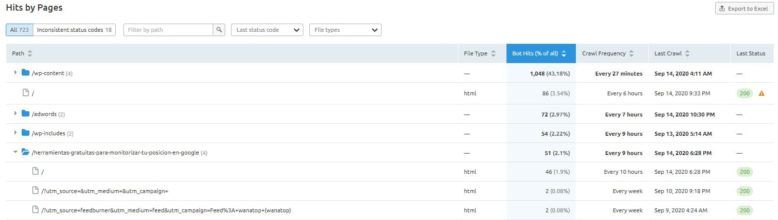

Podemos observar, de manera gráfica, los hits por tipo de bot, código de respuesta y tipo de archivo.

Además, podemos ver el listado de hits por página, tipo de archivo por el bot que hayamos elegido.

Seolyzer

Seolyzer comenzó siendo gratuita para pasar a ser actualmente freemium. Podemos cargar hasta 10000 urls de manera gratuita.

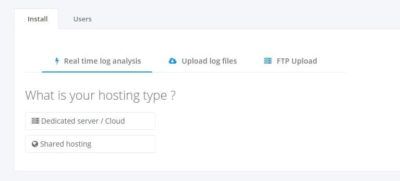

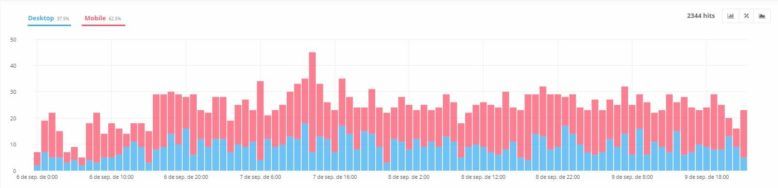

Nos permite realizar bastantes análisis, comparando http vs. https, desktop vs mobile… además de, por supuesto, ver las urls más rastreadas por Googlebot.

Nos da la opción de subir los archivos a mano o conectar a nuestro servidor y que sea automático (algo mucho más cómodo y operativo). Cada vez van metiendo nuevas

Fandango SEO

Fandango SEO se trata de un crawl en la nube (cómo por ejemplo Oncrawl) creado por el SEO Víctor Pérez. Tiene un apartado de logs muy interesante donde podemos subir los archivos a mano o conectar con nuestro servidor para que cada día se actualice. Nos permite poder ver analizar los datos por segmentos, por lo que podemos ver los logs, por ejemplo, de un clúster en concreto que haya configurado previamente.

En definitiva, trabajar con logs debe verse como un análisis muy interesante y complementario, ya que nos puede ayudar a descubrir cosas que de otra forma no podríamos en herramientas como Google Analytics o Search Console.

¿Y tú? ¿También analizas los logs en tu web?

Miguel Añorbe, SEO Tech Lead.

Miguel Añorbe, SEO Tech Lead.